レースゲームのトレイラー。レンダリングが綺麗。

参考資料

How new AI workflows helped create indie VFX short BYE-BYE

インディーズVFX短編映画『BYE-BYE』でAIツールをどのように使用したか記事が公開されています。AIツール使う映像スタジオのPR記事のような雰囲気ですが、メモしておきます。 https://www.cgchanne […]

『KOF ALLSTAR × Street Fighter 6』 Collaboration PV

韓国で開発されたスマホ向けOKFのコラボPVのようです。キャラの見た目がいいですね。

MAPPAこだわりの映像美を3DCG&撮影を中心に紐解く、映画『アリスとテレスのまぼろし工場』

映画『アリスとテレスのまぼろし工場』のメイキング記事が公開されています。 https://cgworld.jp/article/2311-maboroshi01.html ストーリーの鍵となる製鉄所の第五高 […]

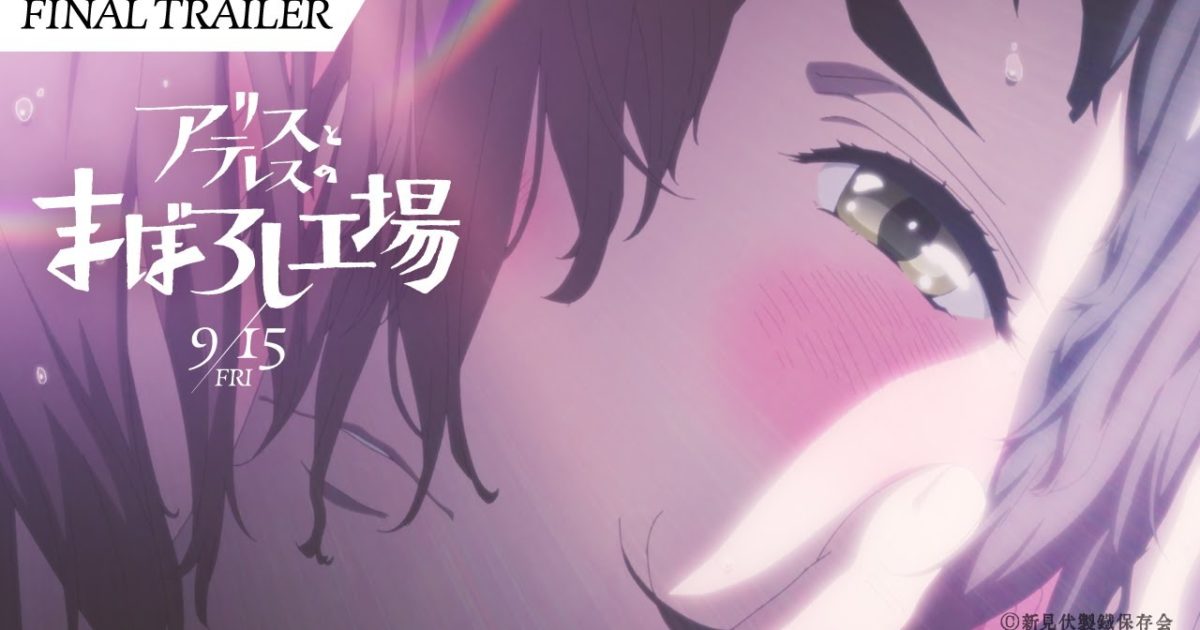

キャラクターアニメーションのための一貫した制御可能な画像-映像合成

静止画像からキャラクターの動画を安定して生成することを目的とした技術論文が公開されています。 https://humanaigc.github.io/animate-anyone/ 概要 キャラクタアニメー […]

MANOR / CHRISTMAS

スイスの デパートチェーンのCMらしい。クリスマスらしいCMですね。

Modo 2024 Roadmap Livestream

Modo 2024 Roadmap Livestream が配信されました。modo 17.0の機能紹介と17シリーズのロードマップが紹介されました。また、17.0 アルファ版が来週公開、正式リリースは2024年の前半の […]

Hublot | Murakami

村上隆とスイスの高級腕時計ブランド「HUBLOT」のコラボモデルのビデオだそうです。白を基調とした背景に透明素材の組み合わせで、ライティングや質感が綺麗です。公式サイト見に行ったら¥43,670,000だった。

LEGO “Holidays”

LEGOのホリデーシーズン向けCMのようです。いろんな作品のキャラクターが登場するのがLEGOらしくていいですね。

Bath & Body Works - Holiday Story

飛び出す絵本がモチーフのホリデーシーズン向けのCM。商品の反射がピカピカしてて視線が誘導されます。

DOVE Stick R&D

砂っぽいパーティクルが綺麗。

USD in 3dsMax

3dsMaxのUSDに関する記事を見かけたのでメモ。 VFX アーティストでパイプラインの開発も手がけるChangsooさんのブログです。USDの解説はMayaを中心に書かれることが多いので、3dsMaxで書かれてるのは […]

HHKB Studio 発売

省スペースキーボード「HHKB」で有名なPFUが、ポインティングスティックやジェスチャーパッドを搭載した「HHKB Studio」を発売しました。レイアウトは英語配列/日本語配列の2種類で価格は 44,000円(税込)で […]

CBS SPORTS - SRX Open

手描きの煙エフェクトがいいですね。

FORD “Impossible”

煙の質感がステキ。最後のビルが出てくるシーンと、空に街が見えるシーンの繋ぎが強引w