画像をドラッグ操作可能にする「DragGAN」のソースコードが公開されました。

https://vcai.mpi-inf.mpg.de/projects/DragGAN/

https://github.com/XingangPan/DragGAN

「DragGAN」は世界中の複数の研究機関の研究者が、デジタル画像を非常に柔軟かつ正確に操作するための新しい手法として開発しました。

画像作成に使われる人工知能の一種である生成的敵対ネットワーク(GAN)の出力を制御する従来の手法とは異なり、DragGANはより高い精度と柔軟性、幅広い応用を提供すします。従来の手法では、手動で注釈を付けた学習データや既存の3Dモデルに依存することが多く、システムの汎用性に限界がありました。

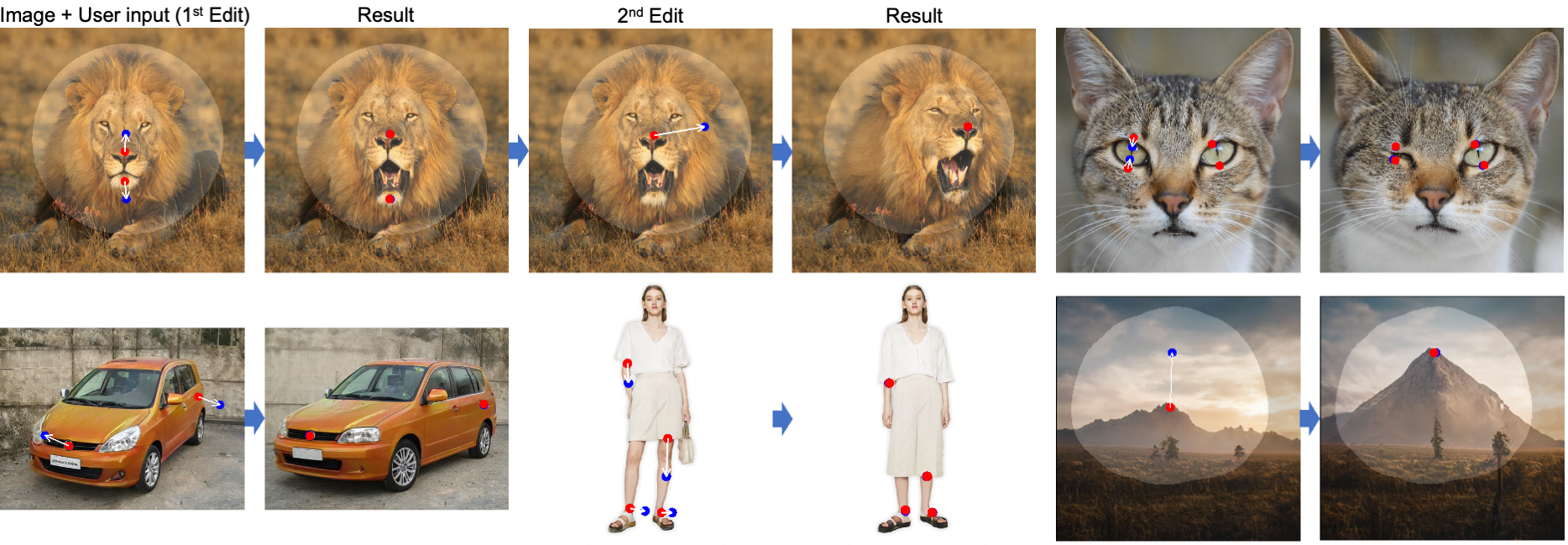

DragGANの特徴は、ユーザーが画像内の任意のポイントを特定のターゲットポイントにインタラクティブに「ドラッグ」できることです。この方法によって、動物、車、人間、風景など、さまざまな画像のポーズ、形、表情、レイアウトを、誰でも非常に正確に変更することができます。

DragGANは主に2つのコンポーネントから構成されます。1つ目は、特徴に基づく動き監視で、選択された点を目標位置に誘導します。もう1つは、GANの特徴量を用いて選択された点の位置を追跡する、新しい点追跡アプローチです。

DragGANの利点の一つは、複雑な状況でも非常に現実的な出力を生成することでです。例えば、不明瞭なコンテンツのもっともらしい表現を作成したり、オブジェクトの自然な剛性に忠実な方法で形状を変更したりすることができます。

このシステムは、画像操作と点追跡の両方において、従来の方法よりも大きな利点を示しています。

GANをドラッグする:生成画像多様体上でのインタラクティブなポイントベースの操作

概要

ユーザのニーズを満たすビジュアルコンテンツを合成するためには、生成されるオブジェクトのポーズ、形状、表情、レイアウトを柔軟かつ正確に制御する必要がある。既存のアプローチでは、手動で注釈を付けた学習データや事前の3Dモデルによって、生成的敵対ネットワーク(Generative Adversarial Network:GAN)の制御性を得ているが、柔軟性、精度、汎用性に欠けることが多い。この研究では、GANを制御する強力な方法でありながら、まだあまり研究されていない方法、すなわち、図1に示すように、画像の任意の点を「ドラッグ」して、ユーザがインタラクティブに目標点に正確に到達する方法を研究する。これを実現するために、我々はDragGANを提案する: 1)特徴量に基づく動き監視により、ハンドルポイントを目標位置に向けて移動させる。2)識別可能なGANの特徴量を活用し、ハンドルポイントの位置を特定し続ける新しいポイント追跡アプローチ。DragGANにより、誰でもピクセルの移動先を正確に制御して画像を変形させることができるため、動物、車、人間、風景など様々なカテゴリのポーズ、形状、表情、レイアウトを操作することができる。これらの操作は、GANの学習された生成画像多様体上で実行されるため、オクルージョンされたコンテンツの幻覚や、物体の剛性に一貫して従う形状の変形といった困難なシナリオであっても、現実的な出力を生成する傾向がある。定性的および定量的な比較の両方により、画像操作と点追跡のタスクにおいて、先行アプローチに対するDragGANの優位性が示される。また、GAN逆変換による実画像の操作についても紹介する。