VFXにおけるAI、機械学習に関する記事が公開されていたのでメモしておきます。 https://www.fxguide.com/fxfeatured/the-art-and-craft-of-training-data- […]

Technical

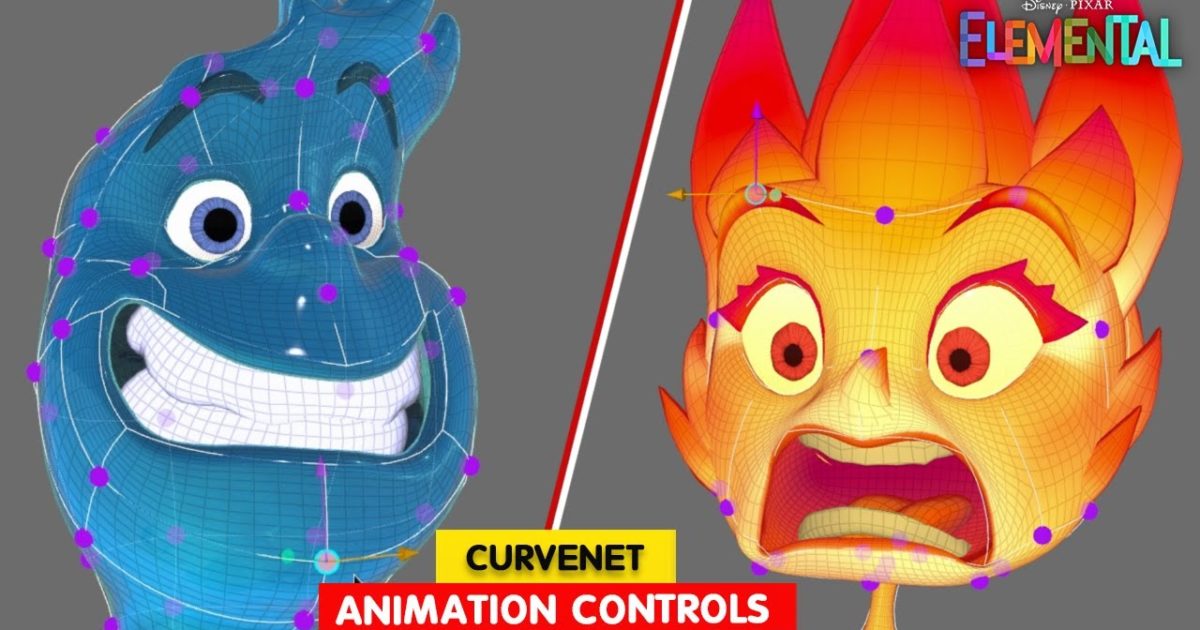

Pixarの「マイ・エレメント」におけるカーブネットのアニメーション・コントロール

Pixarの新作「マイ・エレメント」のカーブを使用したキャラクターリギングのデモ映像が公開されています。カーブを使用したリグは去年論文を公開していましたが、実際に制作で使用されてるグラフィカルなコントローラーを見ることが […]

2D ビデオから 3D シーンを再構築する「NVIDIA Neuralangelo」

2D動画から 3Dシーンを再構築する「NVIDIA Neuralangelo」の映像が公開されています。 現在よく見かけるマルチビュー ステレオ アプローチ(複数の写真から3D形状を復元するやつ)に代わるAI ベースの研 […]

アバター 2 の新しいフェイシャル パイプライン

アバター 2 で使用された新しいフェイシャル パイプラインの記事が公開されています。 https://www.fxguide.com/fxfeatured/exclusive-joe-letteri-discusses- […]

Pixarのプロファイル カーブによるキャラクターの表現

ピクサーのカーブを使用したキャラクター制御の新しいアプローチの論文が公開されています。 https://graphics.pixar.com/library/ProfileMover/ 概要 コンピュータアニメーションは […]

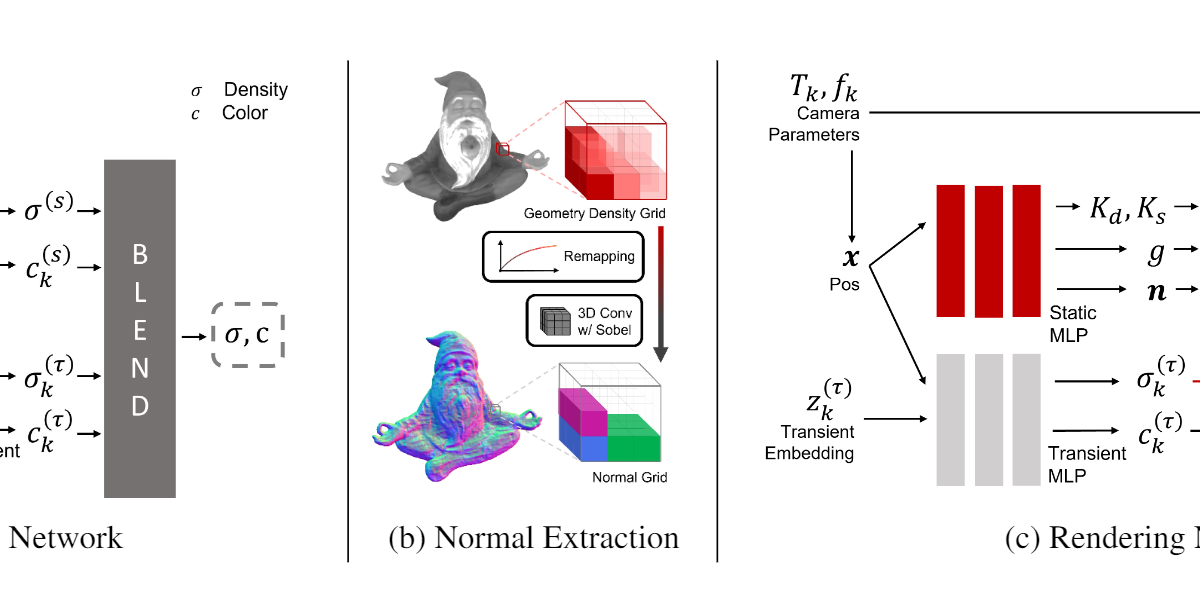

NeROIC: Neural Object Capture and Rendering from Online Image Collections

カメラ、照明、背景が異なるオンライン画像から、3Dオブジェクトを作成する技術が発表されています。 https://formyfamily.github.io/NeROIC/ 概要 カメラ、照明、背景が異なる写真から任意 […]

Vernald rig

Houdiniで作成したリグだそうです。珍しい。 Houdiniで作成したリグテンプレート。ボディはオブジェクトベースのボーンを使用しており、フェイスはワイヤーデフォーマー+シェイプです。

Making WebGL Dance

WebGLを使用したCGに使用される技術をまとめたプレゼン資料のようです。WebGLを使用したインタラクティブな内容がわかりやすくて面白いです。 http://acko.net/files/fullfrontal/ful […]

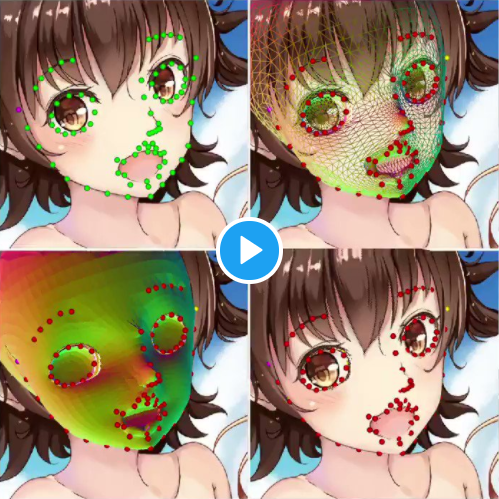

2Dイラストから3Dモデルを自動生成

2Dイラストから3Dモデルを自動生成する実験をしてる人を見かけました。面白いですね。 2Dイラストから3Dモデルを自動生成する実験の続きです。 目のランドマークを増やし、素体の変更を試してみました。今回は @YAN3dc […]

SIGGRAPH Asia 2020 – Technical Papers Trailer

地味だけどベクタースカルプトが便利そう。

SIGGRAPH 2020: Technical Papers Preview Trailer

角煮めくるシミュレーションはいつ見ても凄い。

MPC Film - Creating Scar - Characters of The Lion King

ライオンのリアルさ凄すぎ。 スカーを作るためにチームはまずコンセプトアートを参照することから始めました。 キャラクターのデザイン。モデリングチームは、このアートとライオンの写真を使用して、スカーの形と形を見つけました。モ […]

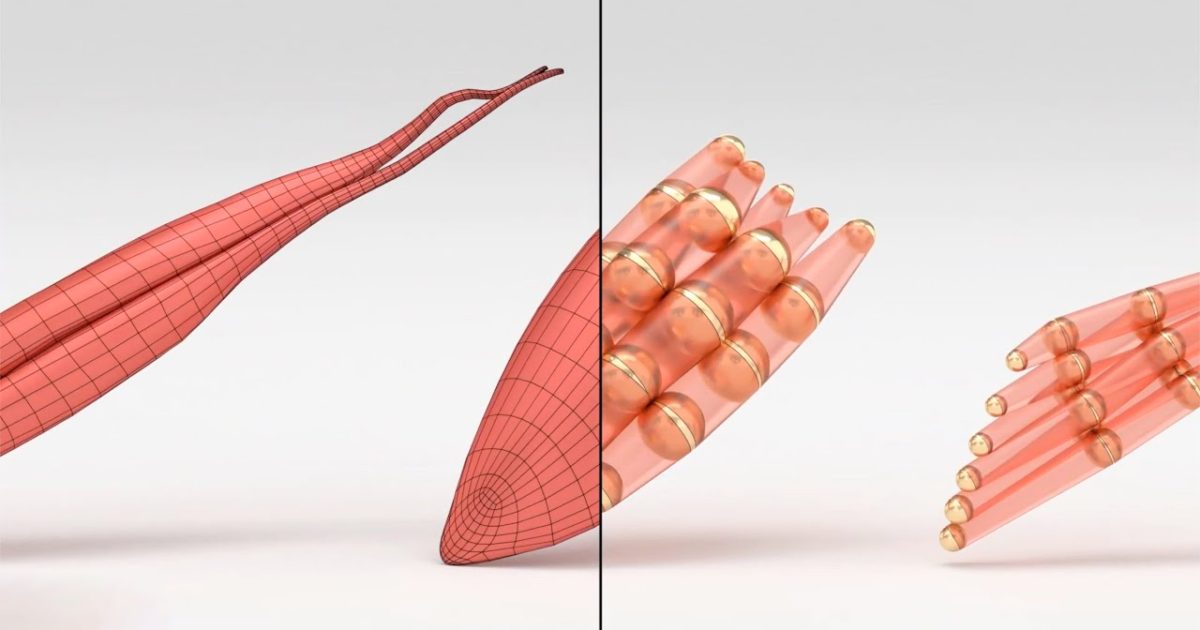

リアルタイム筋肉シミュレーション

VIPER -- 体積不変位置弾性ロッド https://github.com/vcg-uvic/viper

ジョーカー撮影監督が解説、映画の”色”がもたらす効果

ライティングに関する解説ビデオ。とても勉強になります。ユーモアがあって楽しく見られるのもいいですね。

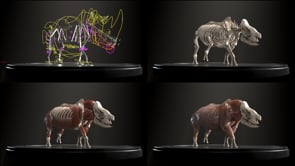

RHINO : LIFE Rigging&Technique

Maxで筋肉までリギングされてるのは珍しい気がする。