Unreal Engine 5.4 がリリースされました。アニメーション関連機能の強化が面白そう。 https://www.unrealengine.com/ja/blog/unreal-engine-5-4-is-no […]

Unreal Engine

Fallout の(LED)バンカー内部

Amazon プライムで公開中のドラマ「Fallout (フォールアウト)」のメイキング記事が公開されています。撮影は 35 mm フィルムを使用し、ボルト内部の撮影ではLEDウォールを使用したセットが使用されており、 […]

Unreal Engine が映像用途での使用を有料化

Unreal Engine、Twinmotion、RealityCapture の価格変更が発表されました。これまでゲーム以外の映像用途などでは無料でUnreal Engineを使用できました。今後は年間収益 $100万 […]

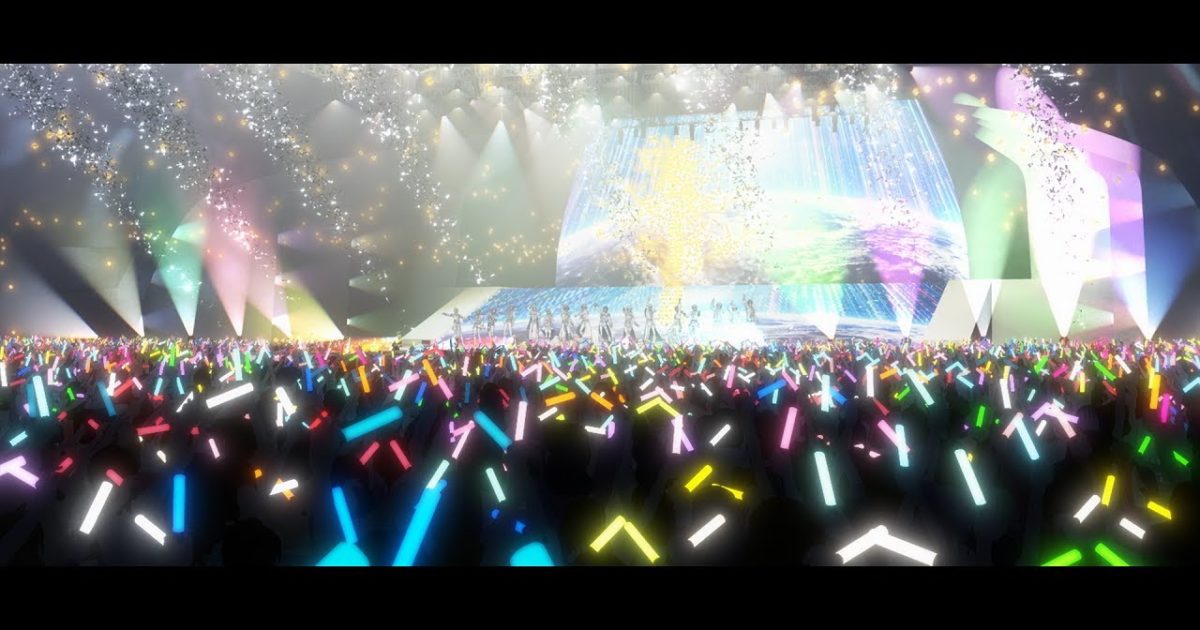

3Dシネマティクスで描く"最上の、切なさを。"『ヘブンバーンズレッド』

『ヘブンバーンズレッド』の3Dライブムービーのメイキング記事が公開されています。 https://cgworld.jp/article/202312-cgw304-hbr01.html https://cgworld.j […]

Epic Gamesが従業員の16%をレイオフ、Bandcampを売却

Epic Gamesが従業員の16% 約 830 人をレイオフし、Bandcampの売却を発表しました。レイオフの約3分の2はコア開発以外のチームとのことです。 Epic Gamessは2017 年の「フォートナイト バ […]

『アリス・ギア・アイギス』プロモーションムービー第3弾

アリスギア 5周年を記念して製作された公式PV第3弾だそうです。レンダリングにUE5、一部LightWaveらしいですよ。 アリスギアアイギス5周年PV第3弾を制作させていただきました!☺️僕の今までの作品 […]

ChaosがAXYZ designとArchvizの4Dヒューマンアニメーション技術を買収

V-Rayを開発するChaosが、人に特化した群集アニメーションツールAnimaを開発するAXYZの買収を発表しました。 建築ビュジュアライゼーション分野では、街中を歩いたり会話する群集の需要が高いようですね。3ds M […]

錦織 博監督&山本健介監督に聞く『劇場版アイナナ』の軌跡

『劇場版アイナナ』のメイキング記事が公開されています。 https://cgworld.jp/article/202307-idolish7-btp1.html https://cgworld.jp/article/20 […]

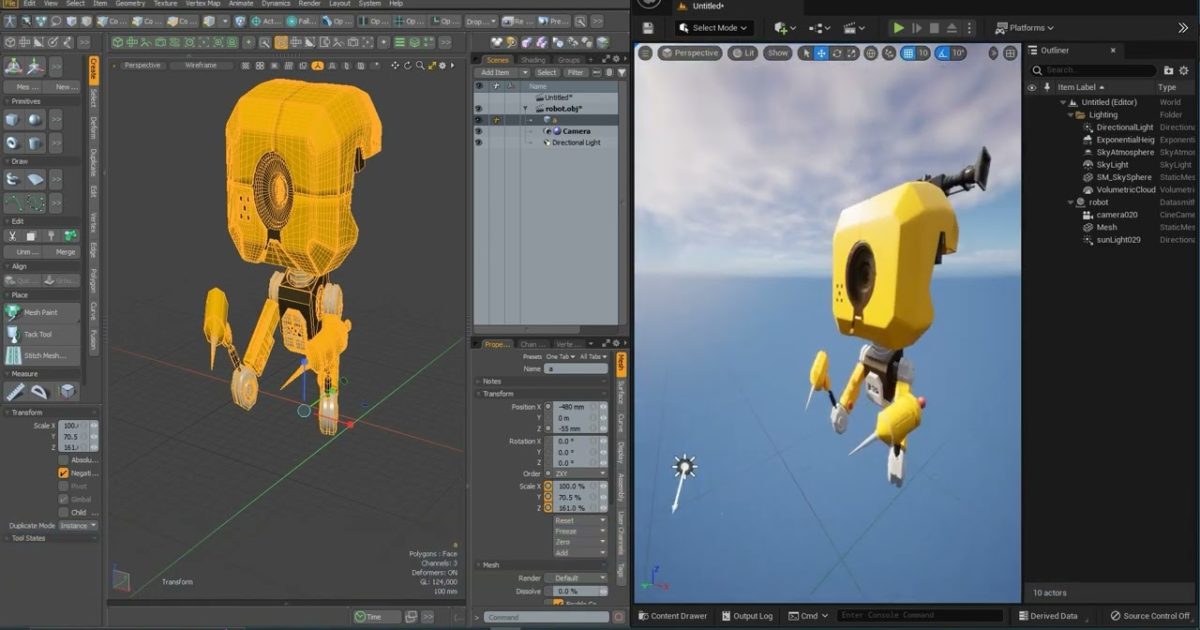

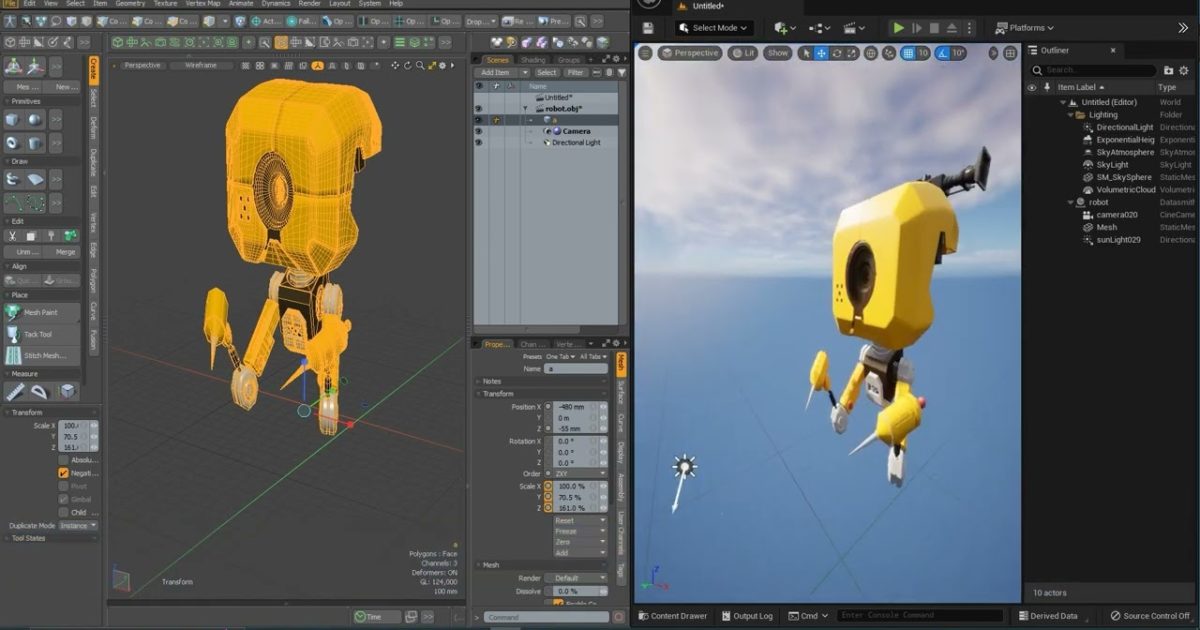

Modo2Unreal パブリックベータ版公開

Datasmithと Direct Linkのすべての機能を使用して、Unreal Engine とリアルタイムで通信するプラグイン「 Modo2Unreal」のベータ版がUnreal Engine マーケットプレイスで […]

Epic が Metahuman Animator 発表

Epic が Metahuman Animator 発表しました。 iPhone やヘルメットに取り付けられたカメラを使用して、MetaHuman キャラクターのフェイシャルパフォーマンスを再現できる機能のようです。 h […]

Unreal Engine 5.2 - Next-Gen Graphics Tech Demo

Unreal Engine 5.2のデモ映像が公開されています。 chaosダイナミクス、岩の上を運転すると岩が転がる アンリアルのchaos車両モデルをセットアップし、トラックのサスペンションと電気モーターがどのように […]

Epic Games Store セルフパブリッシングツールをリリース

誰でもEpic Games Storeに自分のゲームを出せるようになったそうです。Unreal Engineを使っている場合はエンジンの使用料無料。Unityなど別のゲームエンジンを使用している場合でも販売可能らしいです […]

オープンソース パイプライン プラットフォーム「AYON」早期アクセス開始

アニメーションおよび VFX スタジオでのワークフローを高速化するために設計されたオープンソース パイプライン プラットフォーム「AYON」の早期アクセスが開始されました。 https://ynput.io/early- […]

UV-Packer for Unreal Engine リリース

UV-PackerのUnreal Engineバージョンがリリースされました。 https://www.3d-plugin.com/uv-packer-for-unreal-engine-released/ […]

Modo2Unreal ベータ版公開

4D Pipeline が開発する「Modo2Unreal」のベータ版が公開されています。Modo2UnrealはDatasmithとDirect Linkの機能を使用して、Unreal Engineとmodoをリアルタ […]